Classical NLP: BoW, TF-IDF, LDA

Автор: Adapticx AI

Загружено: 2025-12-17

Просмотров: 2

Описание:

In this episode, we explore the classical era of natural language processing—how language was modeled before neural networks. We trace the progression from simple word counting to increasingly sophisticated statistical models that attempted to capture meaning, relevance, and hidden structure in text. These ideas formed the intellectual foundation that modern NLP is built on.

This episode covers:

• Bag-of-Words and the vector space model

• Why word order and semantics were lost in early representations • TF-IDF and how weighting solved relevance at scale

• The limits of sparse, high-dimensional vectors

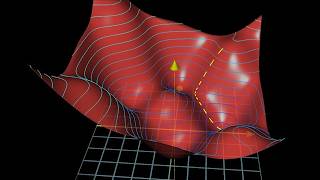

• Latent Semantic Analysis (LSA) and dimensionality reduction

• Topic modeling with LDA and probabilistic semantics

• Extensions like dynamic topics and grammar-aware models

• Why these limitations ultimately led to word embeddings and neural NLP

This episode is part of the Adapticx AI Podcast. Listen via the link provided or search “Adapticx” on Apple Podcasts, Spotify, Amazon Music, or most podcast platforms.

Sources and Further Reading

All referenced materials and extended resources are available at:

https://adapticx.co.uk

Повторяем попытку...

Доступные форматы для скачивания:

Скачать видео

-

Информация по загрузке: