[short] Fast Chain-of-Thought: A Glance of Future from Parallel Decoding Leads to Answers Faster

Автор: Arxiv Papers

Загружено: 2023-11-14

Просмотров: 55

Описание:

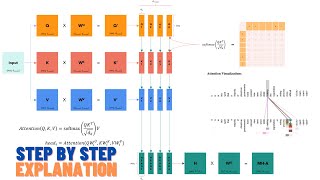

FastCoT is a model-agnostic framework that uses parallel decoding and auto-regressive decoding simultaneously to improve inference time without sacrificing performance in language models.

https://arxiv.org/abs//2311.08263

YouTube: / @arxivpapers

TikTok: / arxiv_papers

Apple Podcasts: https://podcasts.apple.com/us/podcast...

Spotify: https://podcasters.spotify.com/pod/sh...

Повторяем попытку...

![[short] Fast Chain-of-Thought: A Glance of Future from Parallel Decoding Leads to Answers Faster](https://ricktube.ru/thumbnail/C4xVAT2TcxE/hq720.jpg)

Доступные форматы для скачивания:

Скачать видео

-

Информация по загрузке: